Bonjour Pauline, vous avez une carrière impressionnante en matière de gouvernance mondiale de l'IA. Pouvez-vous partager comment votre parcours à l'international influence votre approche de l'IA éthique et inclusive?

En tant que Head of Policy Engagement du Centre pour la Sécurité de l’IA, les questions d’éthique sont au cœur de ma mission. Cela tient avant tout à la dimension intrinsèquement internationale des technologies de l’IA, qui ne connaissent aucune frontière. Au fil de mes échanges avec un grand nombre de représentants du secteur public, du secteur privé et du monde académique, j’ai acquis une conviction forte : une IA de confiance ne peut rester au niveau des principes. Elle doit être actée, incarnée et adaptée aux réalités internationales.

C’est précisément à cette interface entre enjeux techniques et stratégiques que le CeSIA se positionne, afin de passer de la théorie à l’action. En parallèle, mon enseignement à Sciences Po Paris traitant de la sécurité et la gouvernance mondiale de l’IA nourrit cette approche pragmatique : il est essentiel de former les futurs décideurs à penser l’IA comme un enjeu stratégique à forte résonance socio-économique, et non comme un simple objet d’étude technique.

Enfin, mon engagement en faveur d'un leadership inclusif de l’IA — notamment à travers l’initiative Yashoda AI, qui a déjà formé plus de 4 000 femmes en Inde et la plateforme de l'UNESCO Women4Ethical AI — me conforte dans l’idée que l’accès à une IA sûre passe nécessairement par le renforcement des capacités et le dialogue continu.

À votre avis, quels sont les principaux défis auxquels les politiques de l'IA éthique doivent faire face aujourd'hui, en Europe et dans les pays émergents, notamment en Afrique, que vous connaissez bien?

Le défi majeur réside actuellement dans le décalage entre la rapidité du développement de l’IA et la capacité des États à la gouverner. En Europe comme en Afrique, la question des capacités — humaines, financières, institutionnelles et techniques — est centrale.

En Europe, l’enjeu consiste à concilier ambition normative, sécurité et compétitivité économique, en particulier pour les modèles d’IA à usage général. La régulation doit être crédible et efficace sans freiner l’innovation. L’AI Act, et plus récemment le Code de conduite de juillet 2025, ont marqué une étape importante des plus habiles en cherchant à traduire l’engagement volontaire des grandes entreprises technologiques signataires du Code en une conformité accordée au cadre réglementaire européen.

En Afrique, le défi est avant tout d’éviter une dépendance technologique accrue tout en permettant à l’IA de devenir un levier de développement pour ce continent dont la population atteindra 2,5 milliards d’habitants à l’horizon 2050. Cela renvoie directement au risque de « AI Global Divide », clairement mis en évidence dans l’International AI Safety Report présenté sous la direction du professeur Joshua Bengio lors du Sommet de l’IA à Paris en février 2025.

En tant qu'experte dans le domaine, comment voyez-vous la collaboration internationale évoluer pour promouvoir des normes globales en matière d'IA?

Les socles communs établis par l’OCDE en 2019 et par l’UNESCO en 2021 ont posé la première pierre de l'édifice en cadrant le débat international de façon légitime autour de principes structurants. A mon sens, l'évolution de cette coopération internationale revêt deux dimensions complémentaires, l'une diplomatique et l'autre scientifique.

D'une part, l’objectif est maintenant d’ancrer ces principes directeurs dans des cadres normatifs concrets de manière coordonnée. La France, qui assure la présidence du G7 en 2026, dispose à cet égard d’une réelle capacité d’impulsion. Le prochain Sommet de l’IA à New Delhi en février 2026, sous présidence indienne, sera également déterminant pour mesurer la place prise par le Sud global dans les négociations internationales sur la gouvernance de l’IA. Enfin, le tout premier AI Global Dialogue Summit, prévu en juillet à Genève, placera la machine onusienne au cœur du processus de coopération. En 2026, le CeSIA sera pleinement mobilisé autour de cet agenda international dense, avec pour objectif de contribuer à des avancées positives et concrètes.

D'autre part, la coopération internationale doit aussi évoluer vers une approche pragmatique et scientifique, centrée sur l'identification et la gestion des risques. Le tout nouvellement renommé "International Network for Advanced AI Measurement, Evaluation and Science" va dans cette direction.

Pourriez-vous nous parler d'une initiative spécifique au CeSIA qui a eu un impact significatif sur l'adoption d'une IA responsable?

Le "Global Call for AI Red Lines" est sans aucun doute l’initiative la plus structurante du CeSIA ces derniers mois. Lancé avec nos partenaires The Future Society et CHAI à l'occasion de l’Assemblée générale des Nations Unies en septembre 2025, cet appel mondial vise à définir un cadre international excluant explicitement certains usages de l’IA, tels que déléguer à un système d'IA la décision d'utiliser une arme nucléaire.

L’impact de cette initiative est double. En premier lieu, elle a permis de fédérer plus de 300 personnalités internationales de premier plan, dont 12 Prix Nobel, issues du monde politique et diplomatique, des entreprises technologiques, des grandes universités et de la société civile. Par ailleurs, elle a également contribué à déplacer le débat : on ne parle plus uniquement de principes éthiques, mais de décisions politiques concrètes et de lignes rouges explicites.

C’est cette nécessité de sécuriser les technologies et usages de l’IA par la construction d'un agenda politique actionnable qui constitue aujourd’hui l'une des missions centrales du CeSIA.

Quel rôle les entreprises privées devraient-elles jouer selon vous pour garantir que les technologies de l'IA soient développées et utilisées de manière éthique?

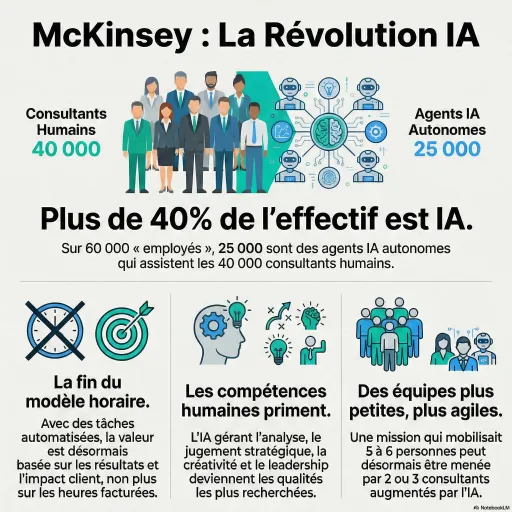

Les entreprises privées sont des acteurs absolument cruciaux de la gouvernance de l’IA, car une poignée d’entre elles maîtrise aujourd’hui l’essentiel de la chaîne de valeur, depuis le développement des modèles jusqu’à leur déploiement à grande échelle. Les enjeux dépassent largement le seul secteur technologique. Selon PwC, l’IA devrait générer 15 700 milliards de dollars de PIB mondial supplémentaire d’ici 2030, dont 6 600 milliards liés aux gains de productivité et 9 100 milliards provenant des effets de consommation.

Cette capacité de transformation économique confère aux grandes entreprises technologiques une responsabilité particulière. Leur rôle commence dès la conception des systèmes, avec l’intégration de la sécurité et de l’éthique dans les processus de développement et se poursuit dans la transparence vis-à-vis des autorités publiques et du public.

C’est précisément pour cette raison que, au CeSIA, nous accordons une importance particulière au dialogue avec les grandes entreprises de la tech. Leur engagement est indispensable pour assurer la sécurité des systèmes d'IA.

Comment anticipez-vous les développements futurs de l'IA sur une échelle mondiale, et quels pourraient être leurs impacts sur les politiques publiques?

L’IA est clairement devenue un enjeu majeur de puissance économique et géopolitique. Les États-Unis, qui dominent le secteur, mobilisent des investissements massifs dans les infrastructures d’IA, avec des projets colossaux tels que Stargate annoncé au début de l'année 2025 pour un montant de 500 milliards de dollars. La Chine semble aussi se lancer dans la bataille de l'IA, en multipliant les investissements d'Etat. De son côté, l’Union Européenne a également lancé sa stratégie d'investissement dans l'IA, visant notamment à mobiliser plus de 200 milliards d’euros en combinant financements publics et privés au travers du programme InvestAI lancé en février 2025.

Parallèlement, nous nous dirigeons vers une généralisation de l’IA dans des domaines toujours plus vastes, une tendance qui transformera profondément l’action publique. Le rapport « Gouverner avec l’intelligence artificielle » publié en septembre 2025 par l'OCDE montre que, sur plus de 2 000 cas d'utilisation de l'IA analysés, 57 % visent déjà à automatiser ou personnaliser les services publics, 45 % à améliorer la prise de décision et 30 % à renforcer la redevabilité et la détection des anomalies.

Pour faire de cette évolution structurelle une réussite, les politiques publiques devront devenir plus agiles, en se fondant sur des évaluations continues des risques plutôt que sur des cadres figés. Cela implique de sécuriser nos environnements numériques, de renforcer les compétences internes des administrations et de former les futurs décideurs.

Pour conclure, quel message souhaiteriez-vous transmettre à nos lecteurs sur l'importance de l'engagement en faveur d'une IA éthique?

Ce que nous faisons de l’IA n’est pas neutre : cela reflète les choix stratégiques de celles et ceux qui la conçoivent, la régulent et l’utilisent. Promouvoir une IA de confiance, c'est lui donner une direction claire et une utilité concrète à l'innovation au service de nos économies et de nos sociétés.

Une IA gouvernée à l'échelle internationale est un formidable levier de progrès, à condition que cet engagement soit collectif. Il concerne les décideurs publics, les entreprises, les universités et la société civile dans son ensemble. Former, coopérer et s'engager pour assurer la sécurité et la gouvernance mondiale de l'IA, est sans nul doute le projet le plus important auquel nous pouvons aujourd'hui — tous — contribuer.

Pour en savoir plus : https://www.cesia.org