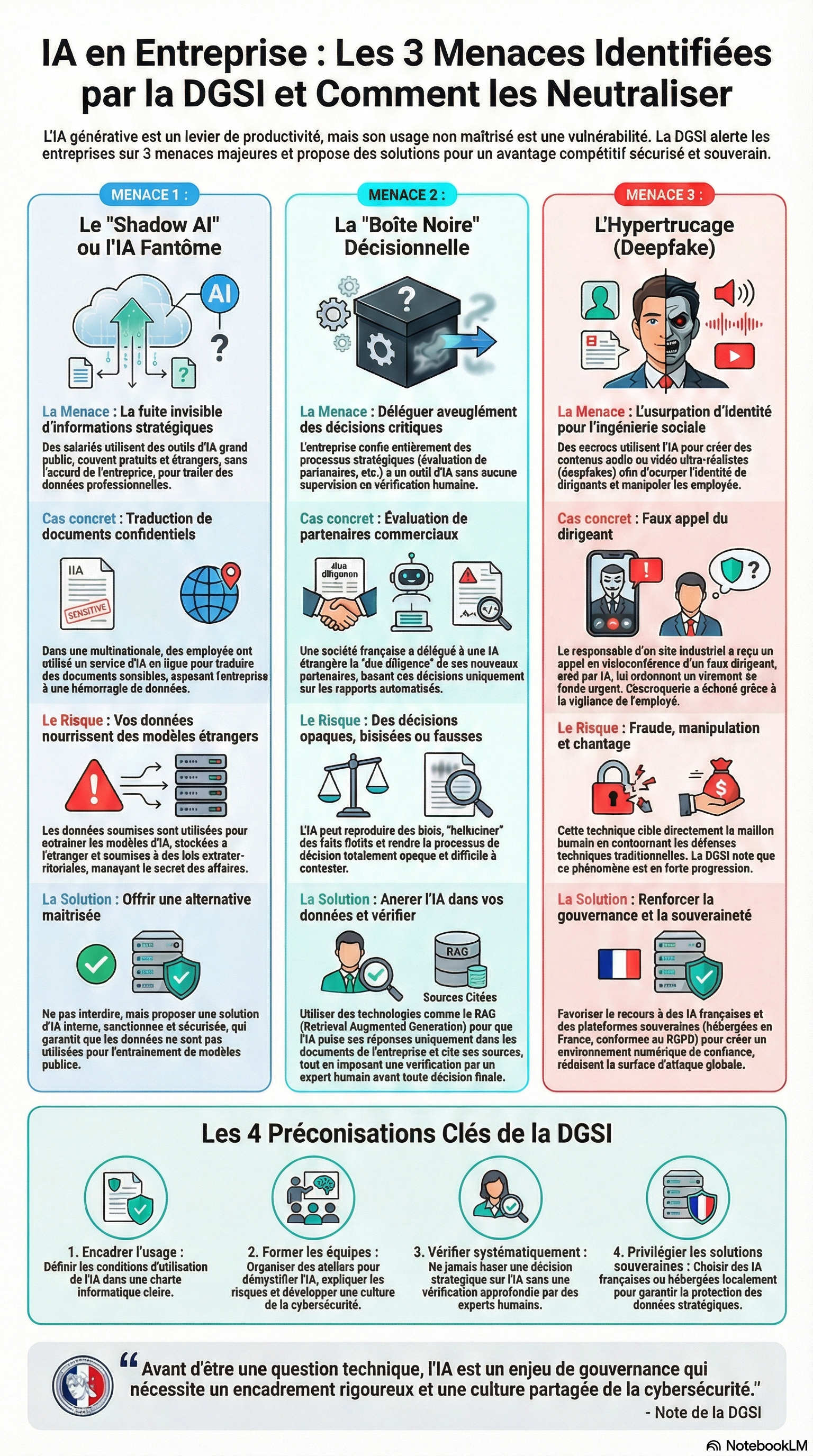

Cette course à la productivité crée une tension stratégique : chaque nouvel usage non maîtrisé de l'IA devient une porte dérobée potentielle pour l'ingérence économique. Face à ce constat, la DGSI a publié une note d'alerte destinée aux entreprises françaises. Cet article détaille les 3 menaces principales identifiées par les services de renseignement et présente des solutions concrètes pour s'en prémunir et établir une véritable souveraineté sur l'IA.

1. Le "Shadow AI" : Quand vos données confidentielles nourrissent des modèles étrangers

La Menace : La fuite invisible des informations stratégiques

La DGSI rapporte un cas concret et alarmant : au sein d'une multinationale, des salariés utilisaient un outil d'IA grand public, développé par une société étrangère, pour traduire des documents confidentiels. Cette pratique, menée sans l'aval de leur hiérarchie, exposait l'entreprise à une hémorragie d'informations stratégiques.

Le risque principal, et le plus insidieux, est que les versions gratuites de ces outils utilisent les données soumises pour entraîner leurs propres modèles. La DGSI souligne que ces informations peuvent être stockées à l'étranger et soumises à des "lois étrangères à portée extraterritoriale", mettant directement en péril le secret des affaires. Ce n'est pas seulement une fuite de données, c'est une érosion de l'avantage concurrentiel de l'entreprise.

La Solution : Canaliser l'innovation pour reprendre le contrôle

La réaction de la multinationale citée par la DGSI valide la bonne approche : elle a immédiatement réagi en "orientant les équipes vers une solution payante d’IA générative acquise par la société" et en formant un "groupe de travail" pour définir une doctrine d'utilisation. C'est la reconnaissance qu'interdire est vain ; il faut proposer une alternative supérieure et maîtrisée.

Une plateforme comme Zenbaia permet de canaliser l'innovation en proposant une "Workplace" unifiée, dotée de multiples agents IA prêts à l'emploi. Cette approche n'interdit pas, elle encourage l'usage de l'IA dans un cadre sanctionné. Elle donne aux équipes l'accès aux meilleurs modèles du marché (Mistral, GPT-4, etc.) tout en garantissant à la DSI une visibilité totale et la certitude que les données de l'entreprise ne sont jamais utilisées pour entraîner des modèles publics. C'est la première étape vers la souveraineté de l'IA.

2. La "Boîte Noire" : Le danger des décisions automatisées et biaisées

La Menace : Déléguer aveuglément des décisions critiques

Le deuxième cas analysé par la DGSI concerne une société française qui avait entièrement délégué l'évaluation de ses nouveaux partenaires commerciaux (due diligence) "sur des marchés étrangers" à un outil d'IA étranger. Aucune vérification humaine complémentaire n'était effectuée, les décisions stratégiques dépendant aveuglément des rapports automatisés.

Cette délégation totale comporte des risques majeurs. La DGSI avertit que l'IA peut reproduire ou même amplifier des biais, produire des "hallucinations" (créer des événements fictifs), et transformer les décisions en "boîtes noires" opaques, difficiles à comprendre ou à contester. Confier une décision aussi critique que le choix d'un partenaire sur un marché complexe à un algorithme non vérifiable est une faille de gouvernance majeure.

La Solution : Garantir la fiabilité avec des IA ancrées dans vos données

La DGSI recommande de systématiquement vérifier les résultats de l'IA par des experts. La technologie de Zenbaia est conçue pour faciliter cette supervision grâce au RAG (Retrieval Augmented Generation). Alors que les IA publiques peuvent halluciner des faits, les agents Zenbaia s'ancrent dans la réalité de votre entreprise. Le RAG transforme l'IA d'un inventeur peu fiable en un assistant de recherche ultra-performant, qui cite ses sources : vos documents.

Les réponses sont puisées exclusivement dans les bases de connaissances internes (processus, catalogues produits, etc.). L'IA n'invente rien ; elle traite vos informations avec rigueur, laissant l'expert humain prendre la décision finale de manière éclairée. Cela ne sécurise pas seulement la décision, cela restaure la confiance et la traçabilité.

3. L'Hypertrucage (Deepfake) : La nouvelle arme de l'ingénierie sociale

La Menace : Quand les escrocs usurpent l'identité de vos dirigeants

La DGSI relate un cas spectaculaire : le responsable d'un site industriel reçoit un appel en visioconférence d'une personne se faisant passer pour le dirigeant du groupe, avec une apparence et une voix identiques, pour demander un transfert de fonds urgent. L'escroquerie a échoué car, "alerté par le caractère inhabituel de cette démarche, le responsable met fin aux échanges et contacte sa direction par les canaux habituels".

Cette technique, l'hypertrucage ou "deepfake", permet de créer des contenus truqués d'un réalisme saisissant à des fins de fraude, de manipulation ou de chantage. Selon la DGSI, ce phénomène est en forte progression et représente une menace redoutable car elle cible le maillon humain par la manipulation.

La Solution : Renforcer la souveraineté pour une résilience globale

Si aucun outil ne peut bloquer à lui seul un appel frauduleux, la résilience à ces attaques sophistiquées se construit par une gouvernance rigoureuse et le choix d'outils souverains. La DGSI recommande explicitement de "favoriser le recours à des IA génératives françaises".

Une plateforme souveraine comme Zenbaia, française et conforme au RGPD, contribue à cette posture de sécurité globale. En proposant des options d'hébergement en France (Cloud privé ou On-premise), elle garantit que les données de l'entreprise ne fuient pas pour alimenter les modèles des attaquants. Elle crée un environnement de haute hygiène numérique où les processus sont clairs et les communications tracées, réduisant la surface d'attaque globale et rendant l'organisation plus résiliente à toutes les formes d'ingénierie sociale, y compris les plus avancées.

4. Les préconisations clés de la DGSI pour une IA de confiance

Encadrer l'usage : Définir précisément les conditions d'utilisation de l'IA dans une charte informatique claire, en spécifiant le niveau de sensibilité des informations qui peuvent y être traitées.

Former les équipes : Organiser des ateliers pour démystifier l'IA, expliquer les risques et développer une culture partagée de la cybersécurité. La vigilance humaine reste le premier rempart.

Vérifier systématiquement : Ne jamais baser une décision stratégique uniquement sur les résultats fournis par une IA sans une vérification approfondie par des experts humains qualifiés.

Privilégier les solutions souveraines : Choisir des IA françaises ou hébergées localement pour garantir la conformité au RGPD et la protection des données stratégiques contre les lois extraterritoriales.

Faire de l'IA un rempart, et non une faille

Face à ces menaces, renoncer à l'IA n'est pas une option ; l'adopter sans gouvernance est une faute stratégique. La seule voie viable est de mettre en place un cadre maîtrisé qui transforme l'intelligence artificielle d'une vulnérabilité potentielle en un avantage concurrentiel sécurisé. Une plateforme orchestrée et souveraine n'est pas un simple outil, c'est l'implémentation d'une stratégie de confiance.

Comme le résume parfaitement la note de la DGSI, le défi est avant tout organisationnel et stratégique.

"Avant d’être une question technique, l’IA est un enjeu de gouvernance qui nécessite un encadrement rigoureux et une culture partagée de la cybersécurité."

-full.webp)

-thumb.webp)

-teaser.webp)