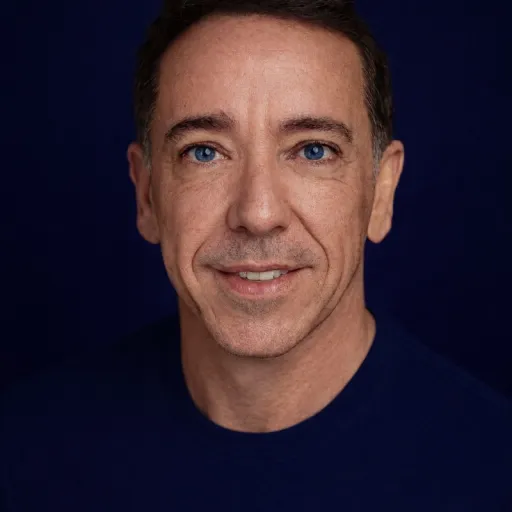

Bonjour Stéphane, comment êtes-vous devenu passionné par l'intelligence artificielle et quel a été le moment clé qui vous a conduit à vous spécialiser dans ce domaine ?

A l'origine, je m'intéressant aux aspects formel de la modélisation et de la programmation en informatique. Je suis notamment passionné par la création du code et des outils nécessaires pour cela depuis mon initiation à LOGO en classe de CM2. Je me suis intéressé à l'IA durant les années 90 et aux méthodes et outils pour programmer ces IA. Le moment clé de ma spécialisation a été ma thèse de doctorat durant laquelle j'ai peu travailler et proposer un modèle d'intelligence artificielle distribuée ou système multi-agent pour modéliser des consortiums d'entreprises industrielles. Cela ma permis de poser les bases de ma première plateforme d'exécution d'agents.

Comment voyez-vous l'évolution du rôle de l'intelligence artificielle dans la société, en particulier dans le contexte des systèmes multiagents et de l'IA distribuée ?

Je pense qu'il n'est plus a prouver que l'IA aura un impact fort dans notre société, que ce soit pour nos entreprises ou dans notre vie quotidienne. D'un côté, ces outils permettront de facilité et de rendre plus efficaces certaines tâches compliquées. De l'autre, il faudra porter une attention particulière à son impact sociétale et économique afin que l'IA reste un outil maîtrisé. Pour moi, l'intelligence artificielle distribuée et les systèmes multi-agents forment un paradigme qui répond à de nombreux problèmes et propose une solution élégante en terme de qualité, passage à l'échelle et résilience du système logiciel. Je ne conçoit par un système d'IA comme une seule IA capable de tout faire. En cela, je m'éloigne de l'AGI. Je suis plutôt partisan d'une école voyant un système d'IA comme une multitude de petites IA, ou agents, capables d'interragir pour résoudre des problèmes complexes. Les propriétés des systèmes multi-agents permettent de faciliter la création et le déploiement de systèmes d'IA en limitant les coûts associés. Les systèmes multi-agents peuvent être vus comme une sorte de lego de l'IA dans lequel chaque brique possède ses propres propriétés et son propre comportement dynamique. Une brique seule ne peut rien. Mais mettre ces briques ensemble permet de créer quelque chose de plus complexe.

En tant que directeur du laboratoire CIAD, pouvez-vous nous expliquer comment vous intégrez une approche collaborative et sociétale dans vos projets de recherche en intelligence artificielle ?

En tant que directeur du laboratoire CIAD, l’intégration d’une approche collaborative et sociétale dans nos projets de recherche en IA repose sur une vision systémique et interdisciplinaire, où la technologie ne se conçoit pas en vase clos, mais en interaction constante avec les acteurs sociaux, économiques et institutionnels. Cette démarche s’articule autour d'une méthodologie agile incluant d'étapes majeures : la définition précise des besoins, l'analyse des données, des informations et des connaissances disponibles, la mise en relation de ces éléments avec les objectifs de l'IA, la conception participative et l'implantation d'un modèle d'IA hybride, et l’évaluation des performances et de l'impact.

La co-construction des connaissances constitue une partie important de notre méthodologie. Nous créons des modèle d'IA spécifiques répondant aux objectifs de nos partenaires qui sont des acteurs variés — chercheurs en sciences humaines et sociales, industriels, associations citoyennes, et institutions publiques. Par exemple, dans le cadre de projets liés à la santé et à l'oncologie, nous associons dès la phase amont des experts du domaine et des utilisateurs finaux. Cette collaboration permet d’identifier des problématiques concrètes, souvent complexes et multiformes, qui ne pourraient émerger d’une approche purement technocentrée. Les ateliers participatifs sont des outils clés pour garantir que les algorithmes développés répondent à des enjeux réels, tout en intégrant des contraintes éthiques. Cette approche itérative favorise une intelligence collective où chaque partie prenante contribue à façonner les objectifs, les données utilisées et les critères d’évaluation des systèmes d’IA.

Avec votre expérience en évaluation des politiques publiques pour le Ministère de la Transition Écologique, comment pensez-vous que l'IA peut contribuer de manière concrète à la transition écologique ?

Dans le cadre de participation à la COMEVAL du Ministère de la Transition Écologique, je n'évalue pas à proprement parlé les politiques publiques. J'ai pour mission d'évaluer les dossiers de mes collègues chercheurs qui sont sous la tutelle de ce ministère. Toutefois, je peux donner le point de vue d'un technologue sur cette thématique. L’IA peut d’abord améliorer la robustesse des évaluations en permettant une analyse fine et systématique de données complexes, souvent hétérogènes et massives. Par exemple, les techniques d’apprentissage automatique permettent de croiser des jeux de données environnementales, socio-économiques et territoriales pour identifier des corrélations ou des tendances qui échapperaient à une analyse traditionnelle. Cela pourrait se traduire par l’utilisation d’outils d’analyse prédictive ou prescriptive pour anticiper les impacts potentiels des projets proposés qui ne sont pas forcément directement lié à l'IA, ou par le recours à des modèles de simulation pour tester la résilience des scénarios de transition face à des variables climatiques ou socio-économiques incertaines. Ces approches permettent de dépasser les limites des évaluations ex post en intégrant une dimension prospective, essentielle pour des politiques publiques qui doivent s’adapter à des dynamiques longues et non linéaires, comme le changement climatique.

Pouvez-vous partager un projet de recherche en IA hybride ou en génie logiciel qui vous a particulièrement marqué, et comment ce projet illustre-t-il l'innovation dans ce domaine ?

Un projet de recherche récent en IA hybride, combinant systèmes multiagents, modélisation sémantique à base d’ontologies et apprentissage automatique, a particulièrement illustré le potentiel innovant de ces approches dans le domaine biomédical. Ce système a été conçu pour assister les biologistes dans l’identification d’interactions protéiques au sein de cellules cancéreuses, en exploitant à la fois des connaissances explicites (bases de données biomédicales, littérature scientifique, données expérimentales, observations cliniques) et implicites (connaissances en biologie). L’objectif était de prédire les effets sur les cellules, qu’ils soient bénéfiques ou indésirables, de médicaments sur des cellules tumorales, en proposant des hypothèses d’interactions protéiques pertinentes.

L’innovation réside dans l’intégration synergique de trois paradigmes : les systèmes multiagents simulent les dynamiques cellulaires à l’échelle microscopique, les ontologies structurent les connaissances biologiques, tandis que les algorithmes d’apprentissage automatique identifient des motifs cachés dans les données. Cette hybridation permet de générer des centaines de pistes d’interactions protéiques, là où une analyse humaine se limiterait à quelques dizaines en un temps équivalent. Le système agit ainsi comme un amplificateur cognitif pour les biologistes, en réduisant significativement le temps et les coûts associés à la sélection de cibles thérapeutiques pour des tests in vitro.

Comment abordez-vous l'enseignement de l'intelligence artificielle à vos étudiants, et comment les préparez-vous aux défis et opportunités de cette discipline en constante évolution ?

Mon objectif est de former des professionnels capables non seulement de maîtriser les outils de l’IA, mais aussi de les questionner, de les adapter et de les intégrer dans une démarche d’innovation responsable. L’IA est présentée comme un partenaire augmentant les capacités humaines, plutôt que comme une solution autonome, et les étudiants sont préparés à évoluer dans un écosystème où la technologie et la société co-évoluent. L’appropriation réflexive des outils d’IA constitue le premier pilier de ma méthode. Plutôt que d’interdire l’utilisation de l’IA, je l’encourage comme un levier pour stimuler la créativité et l’efficacité, tout en inculquant aux étudiants une compréhension profonde de son fonctionnement. Les exercices sont conçus pour exploiter les capacités des modèles d’IA — comme la génération de code ou l’analyse de données — tout en exigeant une analyse critique des résultats produits. Par exemple, lorsque les étudiants utilisent des assistants de codage pour prototyper des solutions, ils sont invités à disséquer les propositions générées, à identifier les biais potentiels ou les inefficacités algorithmiques, et à justifier leurs choix d’optimisation. Cette démarche vise à développer une littératie algorithmique, où l’étudiant n’est pas un simple utilisateur, mais un acteur capable d’évaluer, d’adapter et d’améliorer les outputs de l’IA. Les projets proposés sont délibérément ouverts et contextuels, nécessitant une compréhension fine des problèmes pour lesquels l’IA ne fournit pas de réponse clé en main, comme la conception d’architectures logicielles complexes ou l’intégration de contraintes métiers spécifiques.

La confrontation aux limites technologiques est un élément central de la formation.

Quels sont, selon vous, les principaux défis éthiques auxquels nous devons faire face en intégrant plus d'intelligence artificielle dans notre quotidien, et comment proposez-vous de les surmonter ?

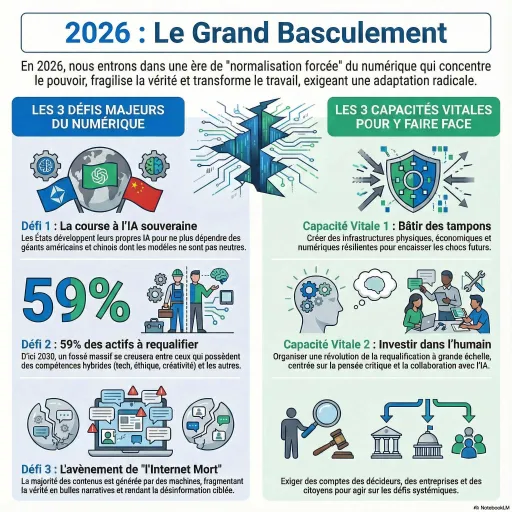

L’intégration massive de l’IA dans les pratiques quotidiennes soulève des enjeux éthiques majeurs, parmi lesquels la préservation de l’autonomie cognitive et la minimisation de l’empreinte écologique occupent une place centrale. L’un des défis les plus pressants selon moi réside dans la tendance à systématiser le recours à l’IA, y compris dans des contextes où son utilité est marginalement justifiée, comme les réseaux sociaux. Ces plateformes, souvent perçues comme des espaces d’échange informel, mobilisent des ressources computationnelles colossales pour des finalités telles que la personnalisation des contenus. Or, ces usages, bien que techniquement impressionnants, génèrent des coûts sociétaux, économiques et environnementaux disproportionnés par rapport à leur valeur ajoutée réelle. Sur le plan sociétal, l’automatisation des interactions sociales via des algorithmes risque d’éroder les capacités critiques des individus, en les habituant à une consommation passive de contenus optimisés pour capter l’attention plutôt que pour stimuler la réflexion.

Pour surmonter ces défis, cela implique, d’une part, de prioriser l’usage de l’IA aux domaines où elle apporte une plus-value démontrée, comme la médecine, l’éducation ou la recherche scientifique, et d’autre part, d’encourager une éducation à l’esprit critique visant à sensibiliser les personnes aux limites et aux biais des systèmes automatisés. L’enjeu n’est pas de rejeter l’IA, mais de l’inscrire dans une logique de responsabilité collective, où chaque acteur, tels que les développeurs, les entreprises, les utilisateurs, est invité à questionner la nécessité et la proportionnalité de son recours. Ainsi, l’esprit critique devient le socle d’une intégration éthique de l’IA, garantissant que son développement serve avant tout l’intérêt général et la durabilité.

Pour en savoir plus : http://www.ciad-lab.fr