Tristan, vous avez cofondé Mozilla Europe et joué un rôle clé dans le lancement de Firefox en Europe. En quoi ces expériences ont-elles influencé votre perspective sur l'avenir des technologies numériques et de l'IA ?

J'ai commencé l'informatique à une époque où Steve Jobs disait souvent que pour lui, l'ordinateur était une bicyclette pour l'esprit. Le vélo est un outil, créé par l'humain, qui lui permet d'aller plus vite, plus loin, avec moins d'énergie qu'à pied. L'ordinateur permettrait donc, de penser, calculer, plus vite, et de communiquer aussi (avec Internet) plus loin. Cette idée m'a vraiment marqué : c'est une vision émancipatrice du numérique, l'ordinateur est au service de l'humain. Cela a toujours porté mes choix au fil de ma carrière. Si j'ai passé 17 ans chez Netscape puis chez Mozilla, c'était parce que l'Internet, le Web, le logiciel libre (ou Open Source si vous préférez) permet de donner le pouvoir à chacun, et d'augmenter les capacités des utilisateurs. Mais seulement voilà, la centralisation des services du Web, la concentration des pouvoirs dans les mains des géants de la Tech, la bataille pour l'attention des utilisateurs et leurs données personnelles, avec tout ce que ça implique en termes de dépendance, de manque d'autonomie stratégique (ce que j'appelais autrefois la souveraineté numérique) et la polarisation croissante de la société, fait que le numérique participe plus à l'asservissement qu'à l'émancipation de chacun. D'où mon questionnement actuel : l'IA, ce tsunami technologique et financier, est-elle émancipatrice ou participe-t-elle à l'asservissement des humains ?

En tant que directeur associé chez OCTO Technology, spécialisé dans les Communs numériques et l'Anthropocène, comment voyez-vous l'intersection entre l'IA et les enjeux environnementaux actuels ?

Cela fait plus de 20 ans que je travaille sur les enjeux environnementaux, et j'ai décidé en 2020 de m'investir encore plus sur le sujet. Dit brutalement, l'humain est en train de détruire l'habitabilité de la Terre. Le climat et les écosystèmes sont fragiles, et l'humain est en train de les déséquilibrer à une vitesse jamais connue jusqu'à présent. On constate ainsi le changement climatique et l'effondrement de la biodiversité. C'est très largement décrit par les scientifiques depuis les années 1970, et ce sont les deux plus gros problèmes auxquels l'humanité doit faire face, très loin devant ce qui fait les gros titres de la presse actuellement (dette, immigration, croissance molle, etc.). Alors qu'apporte l'IA dans ce sombre contexte ?

Vous vous concentrez sur l'impact du numérique sur le climat. Pourriez-vous discuter des moyens par lesquels l'IA peut être utilisée de manière responsable pour atténuer ce problème ?

La technologie est déjà utilisée en faveur du climat, par exemple pour permettre les travaux du GIEC et de l'IPBES (l'équivalent du GIEC pour la biodiversité). Mais l'IA générative, qui révolutionne le numérique en ce moment, n'a qu'un intérêt extrêmement limité dans ces domaines, car fondamentalement, un LLM, c'est le fait d'avoir utilisé les statistiques pour enseigner le langage à une machine surpuissante bardée de GPU. Mais les scientifiques du GIEC et de l'IPBES ont besoin de machines qui font des statistiques (ce qu'elles faisaient depuis longtemps), pas de la génération de texte ! Ce n'est donc pas là qu'il faut chercher les effets positifs de l'IA.

Par contre, je travaille sur l'optimisation de logiciels existants, au sein des entreprises, et l'IA pourrait s'avérer intéressante dans ce cas-là. Comme vous le savez, depuis 50 ans, la loi de Moore a fait qu'on dispose de processeurs qui doublent environ de puissance tous les deux ans. Depuis quelques années, les processeurs classiques de type CPU progressent beaucoup moins vite, alors que ça continue pour les GPU (processeurs dits graphiques qui sont utilisés pour les réseaux de neurones qui font tourner l'IA générative). Le revers de la médaille de la loi de Moore s'appelle la loi de Wirth, qui dit que plus on a des processeurs rapides, plus les logiciels sont lents, parce qu'on ne s'embête pas à les optimiser. On résumait ça en une phrase dans les années 2000 : "ce qu'Intel vous donne, Microsoft vous le reprend".

Mais je reviens à l'optimisation des logiciels existants : c'est un sujet qu'on a délaissé ces 30 dernières années, cela veut dire qu'on a un potentiel inouï d'optimisation si on s'en donne la peine. Mais cela implique de se replonger dans du vieux code, écrit dans des vieux langages, alors que les auteurs sont passés à autre chose. Donc c'est trop coûteux pour être entrepris. Et là, vus les progrès de l'IA générative à ingérer des dizaines de milliers de lignes de code, à écrire de la documentation, à repérer ce qui n'est plus utilisé, ou redondant, ou mal écrit, ou qui ne correspond plus aux usages actuels, on voit bien qu'on dispose d'un outil d'une puissance incroyable. On a enseigné le langage (informatique, mais pas que) à l'ordinateur, il peut nous aider à repérer où il est nécessaire d'optimiser, voire le faire sous contrôle de l'humain. Les premiers efforts en ce sens sont en cours chez OCTO Technology, et c'est très impressionnant, j'ai hâte de voir cela passer à l'échelle industrielle : cela permettrait de faire tourner des applications modernisées sur des vieilles machines et ainsi éviter l'obsolescence de ces machines. Rappelons que l'empreinte du numérique (ressources minérales, eau, pollution, émissions de gaz à effet de serre) provient essentiellement de la fabrication du hardware, pas de son usage ! C'est là que je vois de l'espoir pour que l'IA contribue favorablement à réduire l'empreinte du numérique à terme.

Vous avez une expérience marquante avec la CNIL et le Cigref. Comment ces engagements ont-ils façonné votre approche de la souveraineté numérique face à l'essor de l'IA ?

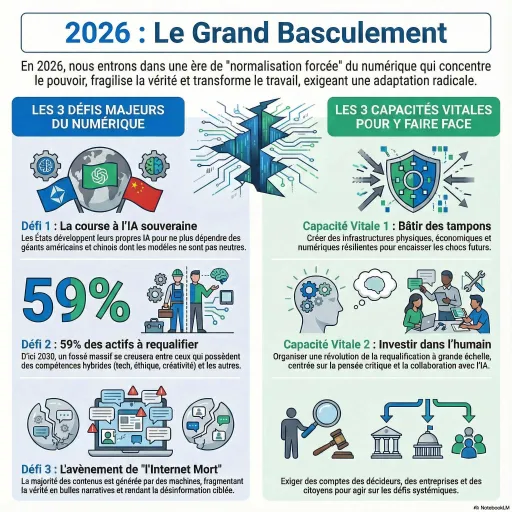

Je me garderais bien de parler au nom de ces institutions, mais voici mon avis. Aujourd'hui, les grands acteurs sont américains et parfois chinois, et le contexte géopolitique est très changeant. Il est très clair que les USA ne sont plus nos alliés. Aussi, d'un point de vue de l'autonomie stratégique (terme que je préfère à celui de souveraineté), il faut être conscient que nous dépendons d'une grande puissance qui peut nous tourner le dos à tout moment, et qui utilise justement cette possibilité comme un levier pour nous menacer. Aujourd'hui, la plupart des services de LLM dépendent donc des USA, et cette dépendance est douloureuse. Expérimenter avec les LLM américains est acceptable, parce qu'il est nécessaire d'apprendre mais il ne faut pas en devenir dépendants. Heureusement, le jeu n'est pas joué : on peut imaginer que les modèles Open-Weight (transposition de l'Open-Source aux LLM) pourraient être utilisables localement en Europe, voire même dans nos téléphones et nos PC, pour ceux qui sont plus petits que les plus gros modèles dits "frontier".

Dans le contexte actuel de mutation technologique rapide, quel rôle voyez-vous pour l'IA dans la promotion des logiciels libres et du web ouvert que vous défendez depuis longtemps ?

Le Web et le logiciel libre sont percutés de plein fouet par l'IA générative. Jusqu'à présent, le langage était le privilège de l'humain. Écrire un texte (qui finirait par exemple sur une page Web), écrire du code, c'était fondamentalement une action humaine. Faire des communautés de logiciel libre aussi, était profondément et exclusivement humain. Mais maintenant, générer des textes ou du code est quasiment gratuit. Enfin on devrait dire "apparemment gratuit", car le coût financier est supporté par des investisseurs qui achètent en fait des parts de marché. Il y a aussi un coût écologique énorme, mais la théorie économique fait qu'on ne tient pas compte des dégâts que subit le vivant.

On peut imaginer que la partie du Web écrite par les humains va se réduire comme peau de chagrin, sous le déferlement de la logorrhée numérique des IA. En plus, il est fort probable que la plupart des humains n'accèdent plus au Web via un navigateur mais pose à leur Chatbot une question qui résumera plusieurs pages Web... jusqu'au jour où elles ne seront plus maintenues par les humains, et seulement écrites par des IA avant d'être ingérées par des IA, avec une dégradation du signal au passage, comme quand on photocopie une photocopie de photocopie, avec un résultat désastreux au final.

Au niveau du logiciel libre aussi, l'impact est énorme. À quoi bon discuter avec la communauté des contributeurs si on peut exiger du code d'une IA ? À quoi bon relire une proposition de correctif par un bénévole si on peut faire réécrire tout un module par une IA ? Pour le contributeur, pourquoi proposer un correctif si une IA est susceptible d'écraser mon travail le lendemain ? Tout le mécanisme contributif est mis sens dessus dessous. J'imagine que certaines communautés continueront à faire du code "à la main" et 100% humain, mais qu'est-ce que ça va donner face à la concurrence IA ? Je l'ignore... D'un autre côté, on peut imaginer des équipes très petites augmentées par des IA, capables de rivaliser avec des grandes communautés, mais plus agiles du fait de leur petite taille. Quoi qu'il en soit, le Web ouvert et le logiciel libres vont être lourdement bousculés par le déploiement massif de l'IA dans le numérique.

Quel conseil donneriez-vous aux entreprises et aux gouvernements qui cherchent à intégrer l'IA de manière éthique et durable dans leurs pratiques ?

L'IA générative peut changer beaucoup de choses, comme je viens de l'expliquer, mais elle est aussi un effet de mode, de "hype" considérable. Pour se l'approprier, il faut expérimenter, faire des erreurs, effacer, recommencer. Et puis il faut se poser des questions : la puissance de calcul que j'utilise est-elle en rapport avec le problème que j'essaye de résoudre ? Est-ce qu'un LLM est la bonne approche alors qu'il en existe beaucoup d'autres moins consommatrices de ressources ? C'est encore difficile à évaluer, car les rapports publiés par les grands acteurs sur l'empreinte de leurs modèles sont d'une très grande imprécision, et pas auditables. On a un peu l'impression qu'ils nous disent "dormez tranquilles braves gens" tout en construisant des datacentres de la taille de Manhattan et en promettant d'en mettre dans l'espace parce qu'il n'y aura pas assez de place sur Terre. C'est très paradoxal. Et par ailleurs, il faut réaliser que nous sommes très probablement dans une bulle spéculative dans le domaine de l'IA, ce qui fait qu'il y a tant de services gratuits alors qu'ils coûtent cher à fournir. Songez qu'OpenAI perd de l'argent sur les abonnements Pro à 200$ ! Après l'explosion de la bulle, jusqu'où monteront les prix ? 300, 400$ par mois ? Mais qui pourra se les offrir ? L'absence de visibilité sur l'empreinte environnementale et les vrais prix rend les décisions très complexes.

Pourtant je crois qu'il faudrait, pour avoir une approche responsable, respecter un principe de proportionnalité : si c'est pour sauver des centaines de vies humaines, alors oui, le recours à des calculs coûteux et polluants a du sens. À l'inverse, si c'est pour corriger mes fautes de français dans un email, alors un correcteur orthographique aura plus de sens qu'un LLM. Surtout en sachant que le mail en question sera probablement résumé par une IA à l'arrivée !

Pour en savoir plus : https://octo.com/

-teaser.webp)